Dans le GCAP, le Tempest mise sur un cockpit virtuel, AR, gestes et biométrie. Promesse: moins de charge mentale. Risque: trop de dépendance logicielle.

En résumé

Le programme GCAP (Global Combat Air Programme) veut faire du Tempest un avion où l’interface devient le vrai “système d’armes”. L’idée centrale est simple: déplacer le cockpit dans l’équipement du pilote. Casque en réalité augmentée, commandes par regard, gestes et voix, puis capteurs capables d’estimer stress et fatigue. Ce “cockpit portable” promet de réduire le temps tête baissée, d’accélérer l’accès à l’information et de reconfigurer l’avion par logiciel, sans toucher à la cellule. Mais ce pari ajoute des risques. Le premier est technique: latence, stabilité, lisibilité en haute accélération et en environnement brouillé. Le second est humain: surcharge cognitive si l’ergonomie est mal calibrée, perte de confiance si l’automatisation “surprend” le pilote. Le troisième est stratégique: une interface numérique est une surface d’attaque, donc une cible. Le Tempest ne “lit” pas dans les pensées au sens science-fiction. Il vise plutôt une fusion de signaux physiologiques et comportementaux pour adapter l’affichage et l’assistance. Le débat réel n’est pas “le dernier avion piloté”, mais jusqu’où déléguer, et comment garder le pilote aux commandes.

Le pari d’un cockpit qui disparaît pour mieux réapparaître sur le pilote

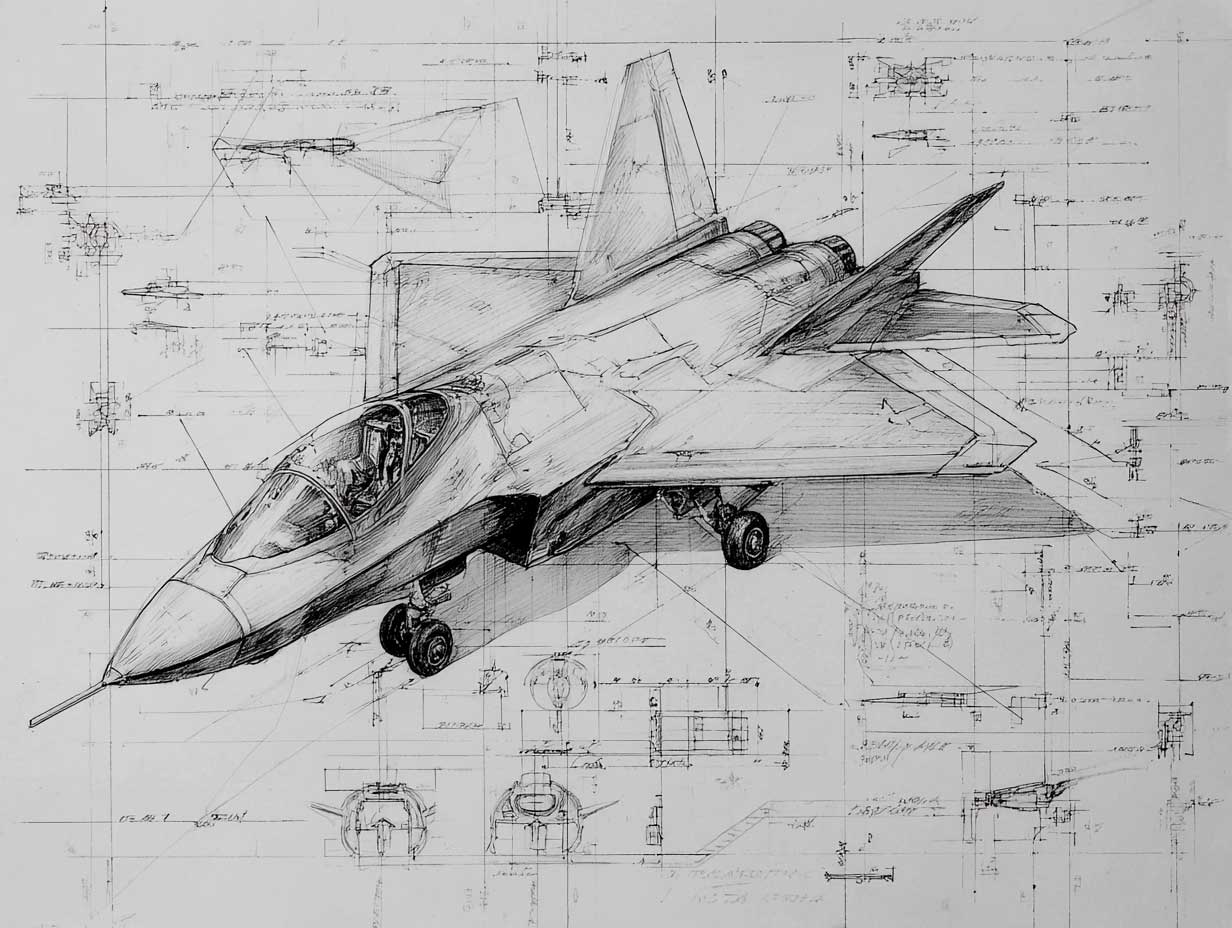

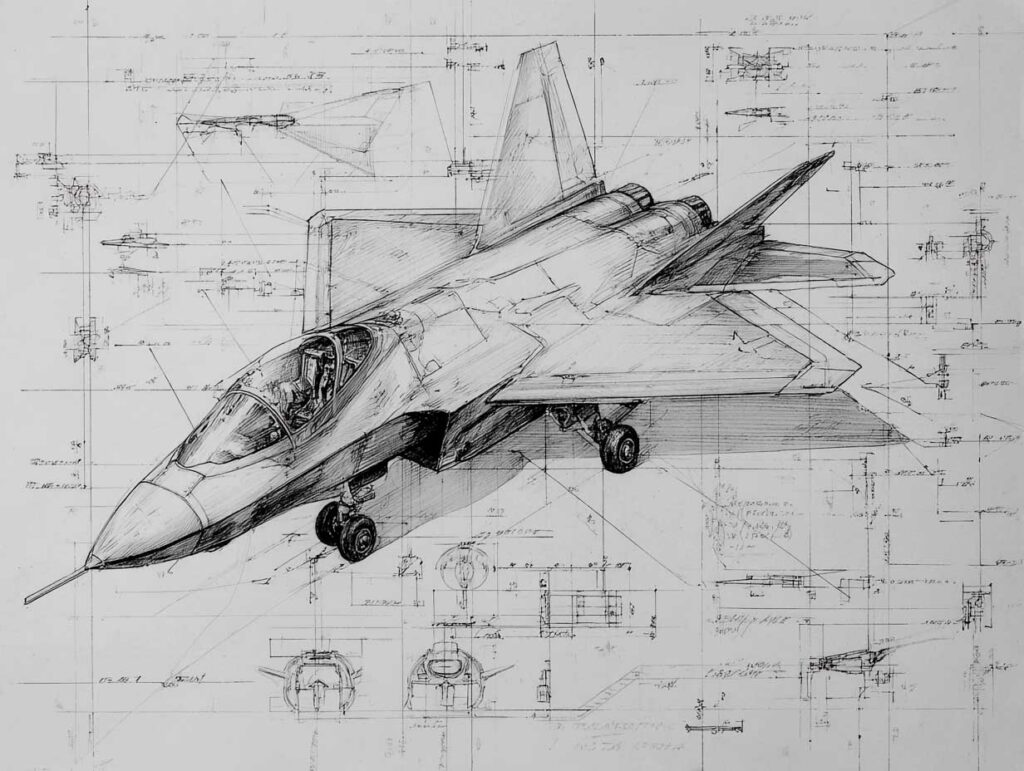

Le concept le plus spectaculaire du Tempest tient dans une image: un cockpit presque vide. Plus de murs d’écrans, presque plus de cadrans. L’ambition est de transformer l’habitacle en volume disponible, et de déplacer l’affichage vers le casque, puis vers l’algorithme.

Le vocabulaire dit tout. On parle de GCAP Tempest comme d’un système de systèmes, où la cellule devient une plateforme, et où le poste de pilotage est un logiciel. Le programme britannique a popularisé l’idée de cockpit portable: l’interface “déménage” dans le casque, les capteurs et l’ordinateur de mission. Concrètement, cela vise trois gains.

D’abord, gagner en adaptabilité. Une suite avionique classique vieillit vite, parce que l’écran, la console et la logique d’interface imposent des modifications lourdes. Un environnement virtuel peut évoluer plus vite, en théorie, au rythme des menaces et des mises à jour.

Ensuite, réduire le “temps tête baissée”. La promesse est d’augmenter le temps “tête haute, yeux dehors”, ce qui reste vital en combat, en ravitaillement, en vol de nuit, et surtout en mission complexe multi-menaces.

Enfin, simplifier le cockpit physique pour limiter masse, câblage, maintenance, et vulnérabilités mécaniques. Ce n’est pas glamour, mais un cockpit moins dense, c’est moins de points de panne.

La réalité augmentée comme nouvelle planche de bord

Le cœur visible du dispositif est le casque. Le projet Tempest met en avant un wearable cockpit fondé sur un casque à affichage avancé, combinant réalité augmentée et, selon les concepts, éléments de réalité virtuelle pour la préparation et certains modes.

L’idée opérationnelle est de projeter les instruments “là où le pilote regarde”. Altitude, vitesse, menaces, navigation, imagerie, état carburant, et données de mission deviennent des calques. Le pilote n’a plus à chercher un écran. L’information vient à lui, sans multiplier les mouvements de tête.

La question critique est la qualité du rendu. En combat, la lisibilité doit rester parfaite malgré les vibrations, la sueur, les variations de luminosité, les accélérations, et les effets physiologiques. Le système doit aussi conserver un mode dégradé crédible. Même si le concept assume “zéro écran”, la réalité opérationnelle pousse souvent vers un secours minimal, ne serait-ce que pour survivre à une panne de casque, à un dommage de combat, ou à un brouillage.

Dans ce modèle, la réalité augmentée ne sert pas seulement à afficher des chiffres. Elle sert à fusionner des capteurs. Si l’avion dispose de plusieurs capteurs (radar, IR, ESM, liaisons de données), l’interface peut représenter une “scène tactique” cohérente. C’est là que l’interface devient un multiplicateur de force: elle fait gagner du temps de décision.

Le suivi oculaire et la gestuelle, du gadget à la logique de sécurité

Tempest ne parie pas sur une seule modalité. Il ajoute des entrées multiples, pour que l’interaction reste possible quand une modalité échoue. Le regard, la main, la voix, et les commandes physiques traditionnelles cohabitent. C’est un point clé: en forte accélération, ou en turbulence, la gestuelle fine devient moins fiable. La doctrine classique consiste à garder des commandes physiques pour les manœuvres critiques, et à déléguer au virtuel ce qui relève de la gestion d’information.

Le suivi oculaire sert à deux choses. D’abord, pointer plus vite. Regarder un élément pour le sélectionner est plus rapide qu’un curseur ou une navigation par menus. Ensuite, gérer l’encombrement. Certains concepts décrivent des affichages qui “s’agrandissent” quand le pilote fixe une zone, puis se réduisent quand il regarde ailleurs. L’objectif est d’éviter l’occlusion, donc de limiter la surcharge visuelle.

Le contrôle gestuel intervient comme une alternative à la souris, au tactile ou aux boutons. L’idée est de “saisir” une fenêtre virtuelle et de la déplacer, de l’épingler, ou de la faire disparaître. Sur le papier, c’est intuitif. Dans les faits, le combat impose une règle brutale: si la gestuelle augmente l’erreur ou la fatigue, elle sera rejetée. Le vrai défi est de calibrer des gestes robustes, peu nombreux, et impossibles à confondre.

Un point souvent sous-estimé est la latence. Même quelques dizaines de millisecondes supplémentaires peuvent altérer la confiance. Une interface rapide mais instable est pire qu’une interface plus lente mais prévisible. En avion de combat, la confiance est une variable tactique.

Les bio-données, la charge cognitive et la promesse d’un cockpit “neuro-adaptatif”

Le discours le plus sensible, en 2025, concerne l’intégration de capteurs physiologiques. Le projet ne vise pas à lire des pensées comme un film. Il vise à inférer un état. D’où l’usage de bio-données: fréquence cardiaque, variabilité, respiration, température cutanée, micro-mouvements, éventuellement activité musculaire, et, à terme, signaux neurologiques si la technologie devient suffisamment robuste.

La finalité annoncée est de surveiller stress, fatigue et attention. Le cockpit deviendrait capable d’estimer la charge cognitive et d’ajuster l’interface. Moins d’alertes inutiles quand le pilote est saturé. Plus d’assistance quand la situation se dégrade. Recommandations contextuelles, reconfiguration automatique des priorités, et délégation de certaines tâches à un assistant virtuel.

C’est une promesse crédible si elle reste humble. Un modèle qui détecte “fatigue probable” peut aider. Un modèle qui prétend connaître l’intention du pilote peut devenir dangereux, parce qu’il risque de surprendre. La ligne rouge est la prédictibilité. En aéronautique militaire, on accepte l’automatisation si elle est compréhensible, testable, et réversible.

Cette logique renvoie à une tendance plus large: des systèmes “neuro-adaptatifs” testés dans des environnements simulés, qui modulent la quantité d’information en fonction de mesures d’effort mental. La question n’est pas seulement technique. Elle est aussi juridique et éthique. Qui stocke ces données? Qui y a accès? Dans quelle mesure peuvent-elles être utilisées pour évaluer un pilote? La biométrie peut améliorer la sécurité, mais elle peut aussi devenir un outil de contrôle social dans une organisation.

L’IA embarquée, entre copilote virtuel et dépendance logicielle

La couche la plus déterminante est l’algorithme. Tempest met en avant un copilote virtuel, capable de filtrer, de proposer, d’anticiper et de coordonner. C’est ici que l’expression “le dernier avion piloté par un humain” trouve son carburant médiatique.

Le risque est de confondre assistance et substitution. Un copilote logiciel peut être excellent pour trier des pistes radar, proposer une manœuvre d’évitement, ou gérer une liaison de données. Mais le combat aérien est aussi affaire d’incertitude, de tromperie et de brouillage. Une IA entraînée sur des scénarios propres peut échouer dans le bruit. Et si l’interface est totalement virtuelle, l’IA devient le “chef d’orchestre” de tout ce que le pilote voit.

C’est la raison pour laquelle la IA embarquée doit être pensée comme une hiérarchie de fonctions, avec des modes dégradés. Il faut pouvoir revenir à une logique plus simple, plus déterministe, quand l’environnement est contesté. Il faut aussi éviter l’effet “boîte noire”. Plus l’assistant est puissant, plus le pilote doit comprendre pourquoi il recommande une action.

Un autre risque, rarement dit frontalement, est la dépendance à l’écosystème logiciel. Un cockpit virtualisé exige des cycles de mise à jour, des tests, des correctifs, et des chaînes d’approvisionnement numériques. Cela peut accélérer l’innovation. Cela peut aussi créer une fragilité si le programme n’investit pas massivement dans la vérification et la cybersécurité.

La cybersécurité et la guerre électronique, le vrai juge de paix

Un cockpit “tout numérique” augmente la surface d’attaque. Cela ne veut pas dire qu’il est forcément vulnérable. Cela veut dire qu’il doit être conçu comme un système résilient dès le départ. Dans un avion de combat, la guerre électronique vise à aveugler, tromper, saturer et dégrader. Si l’interface est dépendante de capteurs fusionnés, la manipulation de ces capteurs devient une attaque indirecte contre le pilote.

Le brouillage peut créer des faux positifs. La fusion de données peut donner une image cohérente mais fausse. Et un affichage AR peut amplifier la confiance dans une donnée erronée, parce qu’elle est présentée comme une évidence visuelle.

La réponse n’est pas de revenir aux cadrans. La réponse est une architecture logicielle sécurisée, des canaux redondants, une séparation stricte des fonctions critiques, et une capacité à afficher l’incertitude. Afficher “probable”, “confirmé”, “source unique” peut paraître trivial. C’est essentiel. Une interface qui sait dire “je ne sais pas” vaut mieux qu’une interface qui invente.

La question du pilote humain, plus politique que technologique

Le débat “dernier avion piloté” masque souvent un sujet plus concret: le nombre de pilotes disponibles et leur coût de formation. Un cockpit qui réduit la charge mentale peut, en théorie, élargir le vivier et accélérer la montée en compétence. Mais un cockpit trop complexe peut faire l’inverse.

Le point le plus franc est celui-ci: un chasseur de sixième génération ne peut pas reposer sur l’héroïsme individuel. Il repose sur une équipe distribuée, sur des données, sur des effecteurs connectés, et sur des procédures. Le pilote reste central, mais il devient un manager de combat, plus qu’un opérateur de systèmes.

Dans ce cadre, l’interface doit renforcer l’autonomie du pilote, pas la réduire. Le pilote doit pouvoir contester l’IA. Il doit pouvoir reprendre. Il doit pouvoir “débrancher” certains automatismes si l’environnement devient imprévisible. Le cockpit portable ne doit pas être une prison logicielle.

Le calendrier 2035 et le risque de promesse trop belle

GCAP vise une entrée en service autour de 2035. Cette date impose une discipline. Les concepts séduisants doivent devenir des briques certifiables. Un casque AR utilisable en combat n’est pas un prototype de salon. Un suivi oculaire robuste n’est pas une démo en laboratoire. Une biométrie fiable ne se résume pas à un capteur. Tout cela demande des essais, des pilotes, des retours, et des itérations.

Le risque le plus classique est l’empilement. Chaque innovation est défendable. L’addition de toutes, simultanément, peut créer un système fragile. La maturité technologique est donc un choix stratégique. Il faudra décider ce qui est indispensable au bloc initial, et ce qui peut arriver par incréments.

Ce réalisme est aussi une force. Si Tempest réussit son interface, il peut exporter une philosophie: celle d’un avion “reconfigurable”, donc adaptable à des menaces évolutives. Mais s’il échoue sur l’ergonomie, il perdra la confiance des pilotes, et l’avion sera jugé sur une chose très humaine: le confort de décision en situation extrême.

La dernière ligne droite, celle de la vérité opérationnelle

Le cockpit virtuel du Tempest n’est pas une fantaisie. C’est une tentative de résoudre un problème qui empire: trop d’informations, trop vite, dans un environnement trop contesté. L’ambition est de donner au pilote une interface qui s’adapte, qui filtre, et qui garde les yeux dehors.

La question n’est pas “l’IA lit-elle dans les pensées”. La question est “l’interface aide-t-elle sans trahir”. Si le cockpit portable réduit la charge mentale, améliore la sécurité, et reste fiable sous stress, il deviendra une norme. Si la virtualisation ajoute de la fragilité, elle sera ramenée à un rôle secondaire, avec des écrans de secours, des modes simplifiés, et des limites strictes à l’automatisation.

C’est là que le Tempest sera jugé. Pas sur des slogans. Sur des heures de vol, des scénarios réalistes, et la confiance froide d’un pilote qui n’a pas le droit de douter.

Sources

- RAF, Team Tempest, “The tech” (section Wearable cockpit), page institutionnelle, consultée en décembre 2025.

- BAE Systems, “BAE Systems eyes novel way of flying” (eye-tracking controls), 21 septembre 2018.

- Institution of Mechanical Engineers (IMechE), “The ‘wearable cockpit’ could change fighter-jet controls forever”, 12 mai 2021.

- The War Zone (TWZ), “Britain Banks On Tempest Future Fighter Program…”, 16 octobre 2020 (tests psycho-physiologiques, eye-tracking).

- Royal Aeronautical Society, “Wearable cockpits – the ultimate human-machine interface?”, 21 août 2018.

- BAE Systems, “Futuristic radar for the UK’s future combat aircraft…” (références aux concepts wearable cockpit), 15 octobre 2020.

- National Defense Magazine, “Industry Partners Form GCAP Electronics Consortium”, 18 septembre 2025.

- IAI (Istituto Affari Internazionali), “The New Partnership among Italy, Japan and the UK on GCAP”, mars 2025 (PDF).

Retrouvez les informations sur le vol en avion de chasse.